DF93电脑,就能松动全模块北极熊大数学模型!

这一令开放源码党感伤的新一代丰硕成果,源自武大邱锡鹏项目组。

关上金沙新闻报道,查阅更多高画质相片

关上金沙新闻报道,查阅更多高画质相片

学术论文由此正式发布,就引起了许多探讨——

在GPT-4刮起热潮后,现代人在赞叹于大词汇数学模型潜能的与此同时,已经开始愈来愈数处思索数学模型掌控权的难题。

对大数学模型普及化而言,FPS松动LLaMA 65B具备十分关键的象征意义!

FPS松动650亿模块大数学模型

学术论文的主要就关键性贡献LOMO(Low-Memory Optimization)强化器,想化解的是十分有限天然资源前提下,大数学模型全模块松动的痛点。

因而,武大项目组的强化路子是这种的:

为的是平衡LOMO的混和精确度体能训练,科学研究相关人员还采行了下列关键步骤。

势能常量:将势能应用于数学模型模块以后,对势能展开常量。

在体能训练期间将某些计算转换为全精确度

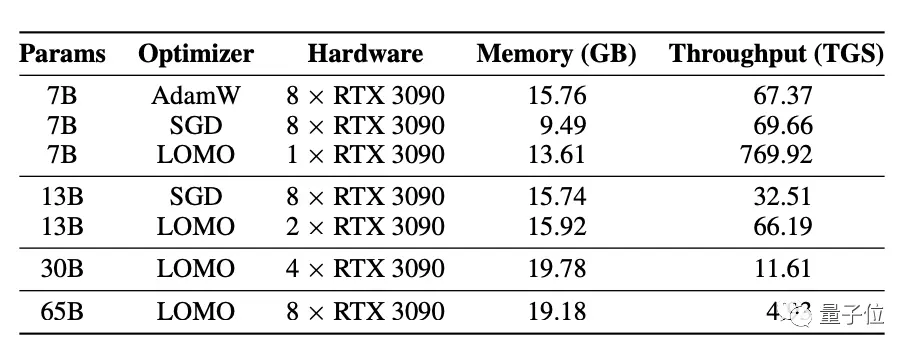

科学研究相关人员分析了使用不同强化器的体能训练过程中,数学模型状态和激活的内存使用情况。

吞吐量测试的结果则显示,在配备8块RTX 3090显卡的服务器上,LOMO可以hold得住LLaMA 65B的体能训练。

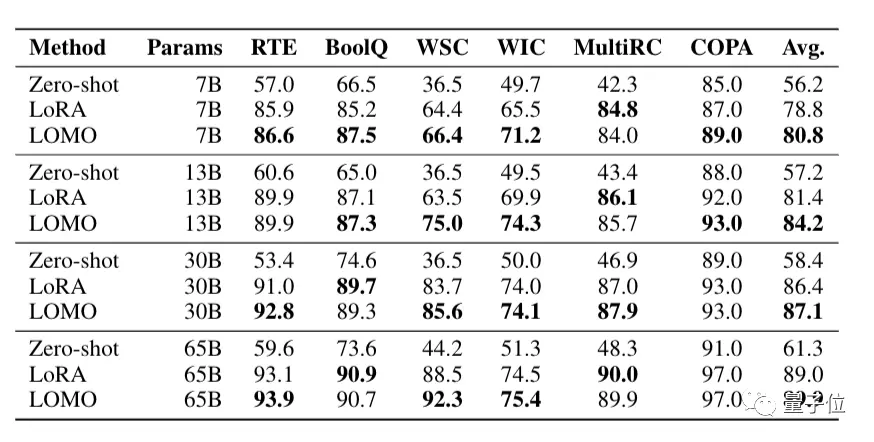

科学研究相关人员还在SuperGLUE基准测试上,比较了LOMO与Zero-shot、LoRA的下游任务性能。

当然啦,尽管在大数学模型体能训练中,8块3090并不是高配,但对普通人而言,还是有点不亲民。

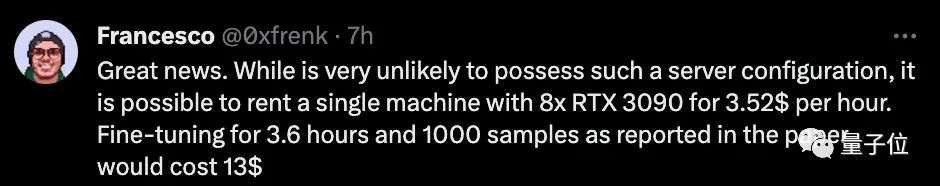

不过,也有人认为,这仍然是个好消息。

虽然不太可能拥有这种的服务器配置,但租这个配置的电脑也不算贵。

目前,使用LOMO体能训练时,大部分内存被模块占用。因而,一个有前景的方向是探索模块量化技术,这可能会大大减少内存使用。

此前,武大开放源码的MOSS大数学模型,正是源自邱锡鹏项目组。

.png)

本文地址:http://www.xcqxcq.com/hot/139232.html

2023东莞小产权房信息_深圳小产权房源_深圳村委统建楼

2023东莞小产权房信息_深圳小产权房源_深圳村委统建楼